Au cours des dernières années, nous avons redoublé d’efforts pour assumer nos responsabilités tout en préservant le pouvoir d’une plate-forme ouverte. Notre travail a été organisé autour de quatre principes:

Dans les prochains mois, nous fournirons plus de détails sur les travaux mis en oeuvres pour soutenir chacun de ces principes. Ce premier projet portera sur

Supprimer. Nous supprimons les contenus préjudiciables depuis le lancement de YouTube, mais notre investissement dans cette tâche s'est accélérée ces dernières années. Vous trouverez ci-dessous un aperçu de nos améliorations les plus importantes depuis 2016. Grâce à ce travail, au cours des 18 derniers mois, nous avons réduit de 80% le nombre de vues sur des vidéos supprimées pour violation de nos règles. Et nous voulons aller encore plus loin.

Développement de politiques pour une plate-forme mondialeAvant de supprimer les contenus qui enfreignent nos règles, nous devons nous assurer que la distinction entre ce que nous supprimons et ce que nous autorisons est bien établie - dans le but de préserver la liberté d'expression, tout en protégeant et en encourageant un environnement dynamique. communauté. Pour cela, nous disposons d’une équipe dédiée à l’élaboration de règles qui examine systématiquement toutes nos conditions d’utilisation pour s’assurer qu’elles sont à jour, favorisent un environnement sécurisé pour notre communauté, sans entraver la liberté d’expression de YouTube.

Après avoir examiné une politique, nous découvrons souvent que des changements fondamentaux ne sont pas nécessaires. Mais nous trouvons également des domaines où nos règles sont vagues ou troublantes pour la communauté. Par conséquent, de nombreuses mises à jour sont en réalité des clarifications de nos règles existantes. Par exemple, plus tôt cette année, nous avons fourni plus de détails sur le moment où nous considérons qu'un «défi» est trop dangereux pour YouTube. Depuis 2018, nous avons apporté des dizaines de mises à jour concernant l’application de nos règlements, dont beaucoup d’éclaircissements mineurs, mais certains plus significatifs.

Pour certains problèmes particulièrement complexes, nous pouvons passer plusieurs mois à élaborer une nouvelle politique. Pendant ce temps, nous consultons des experts externes et les créateurs YouTube pour comprendre les lacunes de notre politique actuelle et pour tenir compte des différences régionales afin de nous assurer que les modifications proposées peuvent être appliquées de manière équitable dans le monde entier.

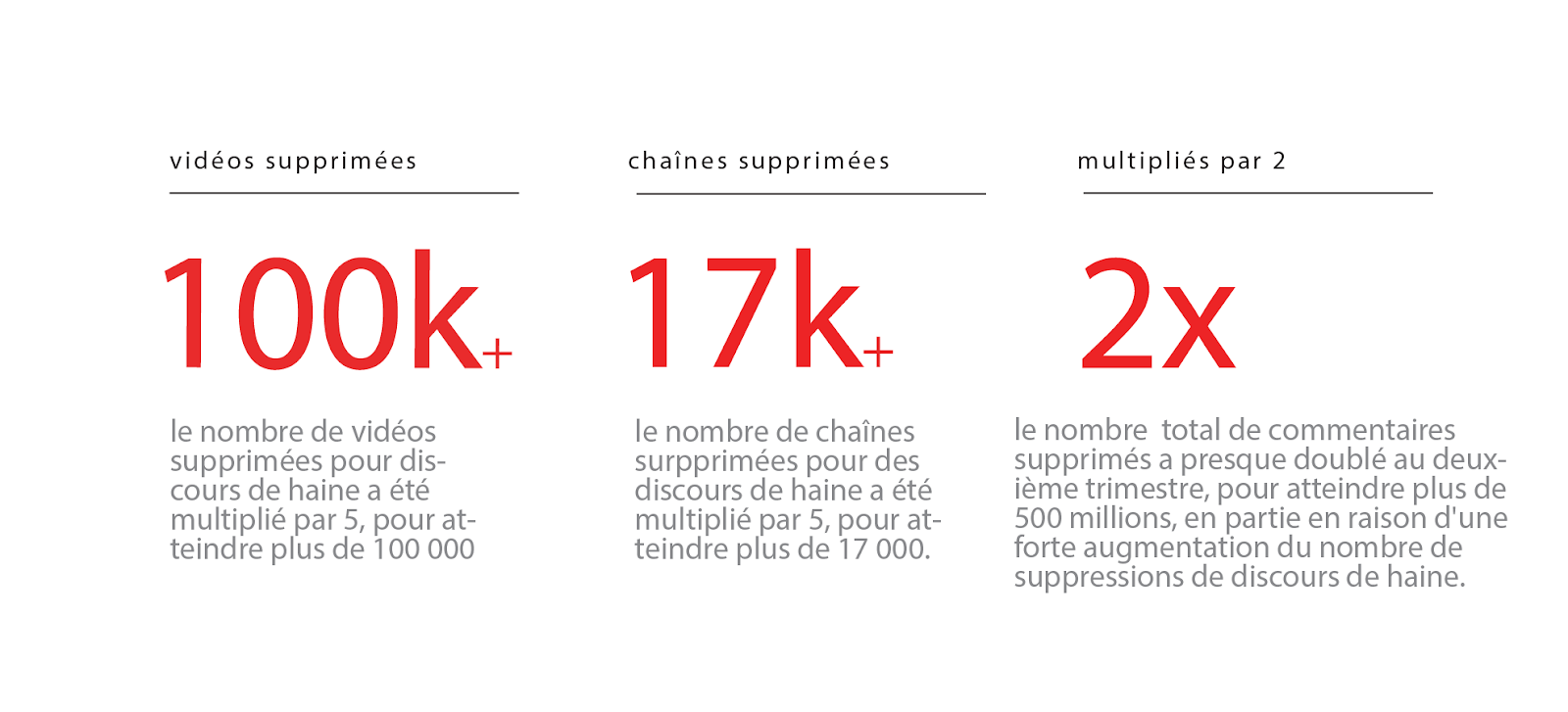

Notre mise à jour concernant les discours de haine a représenté un changement fondamental dans nos politiques. Nous avons passé des mois à élaborer cette nouvelle politique avec soin et à collaborer avec nos équipes pour créer les formations et les outils nécessaires à son application. La stratégie a été lancée au début du mois de juin. Au fur et à mesure que nos équipes examineront et supprimeront davantage de contenu, conformément à la nouvelle politique, notre système de détection grâce à nos technologies d’apprentissage automatique s’améliorera en parralèle. Bien que l’adoption d’une nouvelle politique puisse prendre plusieurs mois, l’impact profond de la mise à jour de notre politique en matière de discours de haine est déjà visible dans les données publiées dans le rapport sur l’application des directives communautaires de ce trimestre:

L’augmentation du nombre de suppressions est due en partie à la suppression d'anciens commentaires, vidéos et chaînes précédemment autorisés. En avril 2019, nous avons annoncé que nous travaillions également à la mise à jour de notre politique en matière de harcèlement, y compris le harcèlement de créateur à créateur. Nous partagerons nos progrès sur ce travail dans les mois à venir.

Utilisation de machines pour signaler un contenu incorrectUne fois que nous avons défini une politique, nous nous appuyons sur une combinaison d’humains et de technologie pour signaler le contenu à nos équipes de modération. Nous utilisons parfois des hashes (ou «empreintes digitales numériques») pour capturer des copies de contenus identifiés comme indésirables avant qu'elles ne soient mises à la disposition des utilisateurs. Pour certains contenus, tels que des images d'abus sexuels sur des enfants (CSAI) et des vidéos de recrutement de terroristes, nous contribuons aux bases de données de hashes partagées du secteur afin d'augmenter le volume de contenu que nos machines peuvent capturer lors du téléchargement.

En 2017, nous avons élargi notre utilisation de la technologie d'apprentissage automatique pour détecter un contenu potentiellement non-conforme, et le soumettre à une révision humaine. L'apprentissage automatique est bien adapté à la détection de motifs, ce qui nous aide à trouver un contenu similaire (mais pas exactement identique) à un autre contenu que nous avons déjà supprimé, même avant sa visualisation. Ces systèmes sont particulièrement efficaces pour signaler des contenus qui se ressemblent souvent - tels que du spam ou du contenu réservé aux adultes. Ces technologies peuvent également nous aider à signaler les discours de haine et autres contenus violents, mais ces catégories dépendent fortement du contexte et soulignent l'importance de l'examen humain pour prendre les décisions nécessaires. Néanmoins, plus de 87% des 9 millions de vidéos que nous avons supprimées au deuxième trimestre de 2019 ont été signalées pour la première fois par nos systèmes automatisés.

Nous investissons beaucoup dans ces systèmes de détection automatisés et nos équipes d’ingénierie continuent de les mettre à jour et de les améliorer en permanence. Par exemple, une mise à jour de nos systèmes de détection de spams au deuxième trimestre 2019 a entraîné une augmentation de plus de 50% du nombre de chaînes que nous avons supprimées pour violation de nos politiques.

Supprimer le contenu avant qu'il ne soit largement vuNous nous efforçons de faire en sorte que les contenu qui enfreignent nos règles ne soient pas largement lu, voire pas du tout, avant d'être supprimé. Comme indiqué ci-dessus, les améliorations apportées à nos systèmes de modération automatisés nous ont permis de détecter et d'analyser ces contenus avant même que ceux-ci ne soit signalés par notre communauté d’utilisateurs. Par conséquent, plus de 80% de ces vidéos signalées automatiquement ont été supprimées avant d'avoir reçu une seule vue au deuxième trimestre de l'année. 2019.

Nous reconnaissons également que le meilleur moyen de supprimer rapidement du contenu est d’anticiper les problèmes avant qu’ils ne surgissent. En janvier 2018, nous avons lancé Intelligence Desk, une équipe qui surveille l'actualité, les médias sociaux et les rapports des utilisateurs afin de détecter les nouvelles tendances en matière de contenu inapproprié, et veille à ce que nos équipes soient prêtes à les traiter avant qu'elles ne prennent trop d’ampleur.

Nous sommes déterminés à continuer de réduire l'exposition des utilisateurs aux vidéos qui enfreignent nos règles. C’est pourquoi, au sein de Google, nous avons demandé à plus de 10 000 personnes de détecter, d’afficher et de supprimer les contenus non conformes à nos règlements. En raison de notre capacité à supprimer rapidement ce contenu, les vidéos qui enfreignent nos règles génèrent une fraction de pour cent des vues sur YouTube.

Par exemple, les 30 000 vidéos que nous avons retirées de YouTube pour discours de haine au cours du dernier mois n’ont généré que l’équivalent de 3% des vues enregistrées par les vidéos de tricot au cours de la même période.

La semaine dernière, nous avons mis à jour notre rapport trimestriel

détaillant les nombreuses actions mises en oeuvre pour garantir l’application de notre règlement de la communauté. Ce rapport montre à quel point la technologie utilisée au cours des dernières années nous a permis de supprimer les contenus préjudiciables sur YouTube plus rapidement que jamais. Il souligne également que l'expertise humaine reste un élément essentiel dans les efforts mis en œuvre, alors que nous travaillons à l'élaboration de politiques réfléchies, à la révision du contenu avec soin et au déploiement responsable de notre technologie d'apprentissage automatique.